¿Inteligencia Artificial fuerte versus Inteligencia Artificial débil?

17 de junio de 2019 AI

AIA menudo, cuando se habla de Inteligencia Artificial, tendemos a tomarlo como un todo e imaginarnos maquinas inteligentes y con conciencia que superaran la humanidad. Una suerte de futuro Terminator, donde una inteligencia no-humana pone en peligro el futuro de nuestra existencia. Incluso, discursos como la época de la posverdad, big data, machine learning tienen un tono casi apocalíptico.

«Inteligencia artificial» es una metáfora que engloba métodos, funciones y una serie de algoritmos.

Así que para entender que quiere decir Inteligencia Artificial, tenemos que hacer este ejercicio de ir más allá de la metáfora. Por ejemplo, para los que trabajan en el campo de la informática teórica o ingeniería, Inteligencia Artificial se usa como paraguas para: Machine Learning, Petri Networks, Neural Networks, Distributed Computing, Semantic Web, Natural Language processing etc. Estos todos son una serie de algoritmos, funciones y métodos pata hacer que los sistemas informáticos lleguen a ser capaces a procesar cantidades muy grandes de información.

Podríamos, en grandes líneas (y simplificando un poco) definir el Strong AI y Weak AI de la siguiente manera:

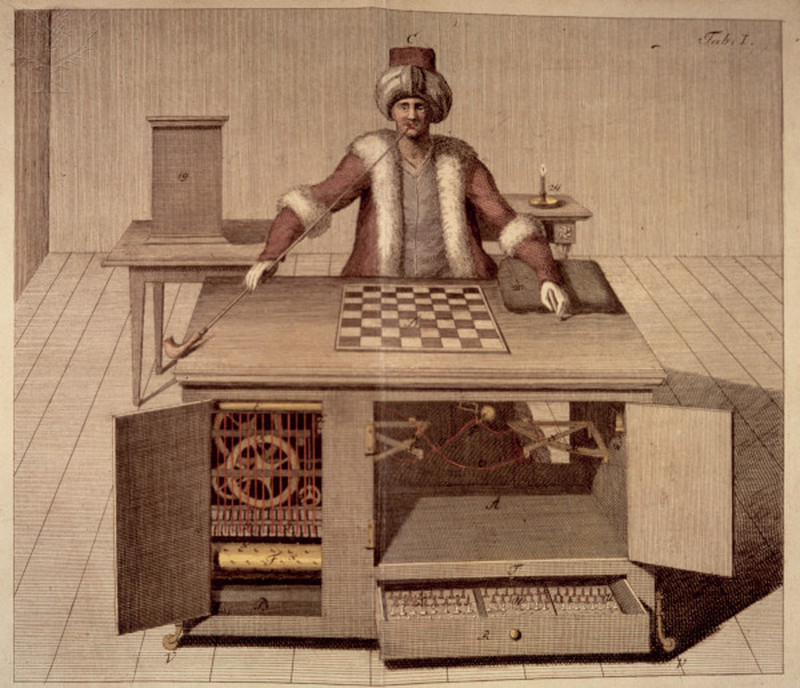

* Strong AI: los poderes mentales o el carácter de una Inteligencia Artificial son como mínimo los que tiene un humano, una inteligencia artificial puede llegar a tener una consciencia. Además, los defensores del Strong AI comparan la mente humana con el ordenador. Es a decir, una Strong AI, podría hacer juicios, pensar racionalmente, aprender, comunicar en lenguaje natural, entre muchas otras cosas. Y así, llegar a tener e incluso superar un ser humano. Para medir el nivel que una AI tiene, hay una serie de tests, uno de ellos – el Turing Test.

* Weak AI: representa la construcción de maquinas de procesamiento de dados e información que ayuden al hombre en ciertas tareas. Son sistemas que están mejorando en cuanto a productividad y efectividad en procesar cantidades grandes de datos, tomar decisiones, etc. pero sin poder superar a éste.

La diferencia entre la IA fuerte (Strong AI) y IA débil (Weak AI) se ha empezado a estudiar sobretodo a partir de que el filosofo Searle presente un contra-argumento a la IA fuerte, el así llamado «The Chinese Room Argument» y también, teniendo en cuenta el argumento del primer teorema de incompletitud de Gödell, que afirma que nunca una maquina podría adquirir algún tipo de inteligencia humana. Los contra-argumentos a la IA fuerte no han dejado de aparecer, como por ejemplo el filosofo heideggeriano Hubert Dreyfus, que dedico gran parte de su obra argumentando como la IA llegaría a fallar porque simplemente el cerebro humano y mente humana no son análogas con el hardware y software de un ordenador.

La diferencia entre la IA fuerte (Strong AI) y IA débil (Weak AI) se ha empezado a estudiar sobretodo a partir de que el filosofo Searle presente un contra-argumento a la IA fuerte, el así llamado «The Chinese Room Argument» y también, teniendo en cuenta el argumento del primer teorema de incompletitud de Gödell, que afirma que nunca una maquina podría adquirir algún tipo de inteligencia humana. Los contra-argumentos a la IA fuerte no han dejado de aparecer, como por ejemplo el filosofo heideggeriano Hubert Dreyfus, que dedico gran parte de su obra argumentando como la IA llegaría a fallar porque simplemente el cerebro humano y mente humana no son análogas con el hardware y software de un ordenador.

Y sin duda, nuevos estudios demuestran que la mente humana no es como un ordenador. Esto hace que desde la filosofía se centre más en la IA débil por dos razones: primero, porque des del vertiente lógico se pueden estudiar los algoritmos y las funciones matemáticas con mejor claridad; y, segundo, y además, desde una perspectiva clásica de la filosofía continental, la debilidad de la IA se podría argumentar a partir de la siguiente cuestión: nosotros los humanos fabricamos las herramientas y sistemas y, por tanto, incluye dentro nuestra propia fragilidad, la posibilidad del fallo. Como dice Jean Francois Dortier en La cerveau et la pensée:

«Cuarenta años después de su creación la importancia de la IA está, cuando menos, mitigada. Los especialistas se refieren cada vez más (después del análisis de Searle) al proyecto de una «IA débil» opuesto a la «IA fuerte» del principio. El proyecto de la «IA fuerte» era encontrar y reconstruir la forma en que el hombre piensa y después superarla. El proyecto de la «IA débil» es más modesto. Se trata de simular comportamientos humanos «considerados inteligentes» por los métodos de la ingeniería, sin preocuparse de saber si el hombre procede de la misma manera. Hoy día se prefiere hablar de lógicas «de ayuda» a la creación o a la toma de decisiones más que de máquinas que remplazarían al hombre».

Esto es lo que cita la filosofa Catherine Malabou para hacernos ver que la inteligencia artificial no es otra cosa que una metáfora cibernética y que, por esto, no podemos ver que vivimos en un periodo de inteligencia artificial llamado débil. Y, ciertamente, mirado de una perspectiva (post)estructuralista, hacer un análisis filosófico de la IA débil es muy fructífero. Si por inteligencia artificial entendemos el conjunto de métodos de ingeniería que intentan de simular de la manera en lo que los humanos actúan, entonces no cabe duda de que este proceso de aprendizaje de la maquina se lleva a cabo mediante la acumulación de grandes cantidades de dados. Esta acumulación es lo que produce un exceso. En este sentido, este exceso o la Inteligencia Artificial como exceso es la propia condición de posibilidad del fallo, del accidente – al mismo tiempo demostrado la imposibilidad de una maquina que funcione perfectamente y supere lo humano. Tales accidentes que pasaron en los últimos años como Spectre o Meltdown son sólo unos de los efectos de la acumulación de dados que demuestran la falibilidad de los sistemas de IA.

grandes cantidades de dados. Esta acumulación es lo que produce un exceso. En este sentido, este exceso o la Inteligencia Artificial como exceso es la propia condición de posibilidad del fallo, del accidente – al mismo tiempo demostrado la imposibilidad de una maquina que funcione perfectamente y supere lo humano. Tales accidentes que pasaron en los últimos años como Spectre o Meltdown son sólo unos de los efectos de la acumulación de dados que demuestran la falibilidad de los sistemas de IA.

Pero, por otra parte, otros artículos científicos y experimentos muestran como sistemas de IA han resuelto problemas matemáticos que los humanos no han podido. Pero la pregunta clave es: ¿la matemática de las maquinas inteligentes es la misma de los humanos? ¿Es matemática lo que realmente hacen o es otra cosa?

La distinción entre IA fuerte e IA débil se ha hecho des de la perspectiva antropológica, de la mirada del humano: adquisición de una conciencia humana y superación de esta por una parte, limitación en tanto que imposibilidad de imitación de la mente humana por otra parte.

Pero, lo más interesante es mirar hacia las metamorfosis que la inteligencia supone. Un pequeño intento de hacer esto lo hace también Malabou en su libro.