¿Por qué empatizamos con los robots?

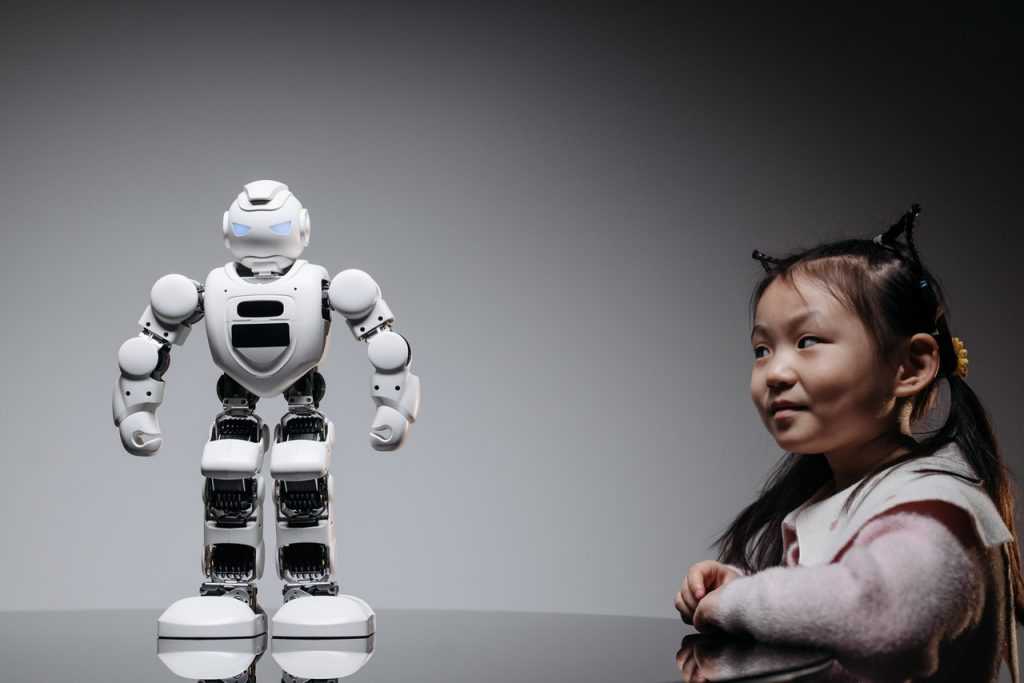

01/07/2021 Foto: cottonbro en Pexels.

Foto: cottonbro en Pexels.(Més avall trobareu la versió en català d’aquest contingut.)

El futuro de la IA, las emociones y las relaciones sociales

Estamos en al año 2001, camino a Júpiter y a bordo de la nave Discovery One. El Dr. David Bowman, después de haber salvado su vida por los pelos, se dirige al núcleo del procesador del HAL 9000, un ordenador equipado con personalidad humana que, con el objetivo de asegurar el éxito de la misión, ha intentado acabar con la vida del Dr. Bowman. Mientras éste desconecta manualmente las diferentes unidades del núcleo del HAL 9000, el ordenador le habla: “Dave, sólo ha sido un error de cálculo, pero ahora ya estoy bien”. Cuando eso no funciona, el HAL 9000 cambia de estrategia: le pide y le suplica al Dr. Bowman que no le desconecte. Cuando esto tampoco funciona, el ordenador adopta un nuevo enfoque: dice que tiene miedo. Dice que su mente se está yendo. Dice que puede sentirlo. El Dr. Bowman, haciendo caso omiso a las palabras del HAL 9000, consigue desactivarlo y recupera el control de la nave espacial. Esta es, quizás, una de las escenas más famosas del clásico cinematográfico de Stanley Kubrick, “2001: A Space Odyssey”. En ella se nos muestra un súper-ordenador que no solo posee una inteligencia extraordinaria, sino también una capacidad de interaccionar con los seres humanos que, por ahora, queda lejos de la tecnología que tenemos en nuestro mundo actual. Como parte de esa extraordinaria capacidad de interacción, el ordenador hace referencia a sus emociones y a su experiencia subjetiva: dice que tiene miedo y que puede sentir como su mente se va. ¿Puede, el HAL 9000, sentir eso realmente, o es sólo una estrategia para protegerse de la determinación del Dr. Bowman de desconectarle?

Aunque se trate de obras de ciencia ficción, novelas y adaptaciones cinematográficas como “2001: A Space Odyssey”, de Stanley Kubrick, películas como “Ex Machina”, de Alex Garland, o como “A.I.: Artificial Intelligence”, de Steven Spielberg, o clásicos de la literatura como los relatos recopilados en “I, robot”, de Isaac Asimov, han explorado numerosas veces las posibles relaciones entre la inteligencia artificial (IA) y las emociones. Aunque lo que vemos en esas obras aún queda lejos de la tecnología actual, las preguntas que abren son cada vez más relevantes para entender los efectos que la integración entre la IA y las emociones pueden llegar a tener en un futuro próximo de los avances tecnológicos. ¿Cuáles son las preguntas que debemos hacernos cuando hablamos de IA y emociones? ¿Dónde acaba lo humano y empieza lo artificial? ¿Cómo podría afectar, en nuestras relaciones sociales, convivir con robots capaces de entender y mostrar emociones?

Emociones percibidas: ¿realidad, o simulación?

Aunque la cantidad de temas en los que nos podríamos centrar entorno a estar preguntas es enorme (y, ciertamente, imposible de condensar en una publicación de este tamaño), hay una pregunta fundamental y recurrente que, tanto en la ciencia ficción, como en conversaciones alrededor del futuro de la tecnología, nos hacemos a menudo: ¿podrá la IA llegar a tener emociones algún día? Al adentrarnos en esta pregunta, es importante partir de una diferencia importante: una cosa es sentir emociones, y otra muy distinta es simular, o fingir emociones. Esta distinción es clave porque, aunque en ambos casos podemos percibir, desde fuera, que hay una emoción presente, sabemos que la emoción no es genuina en los dos casos: por ejemplo, una actriz puede aparentar que está enojada con nosotros, pero sabemos que en realidad solo está simulando, o fingiendo sentir esa emoción, pero que no está realmente enojada. Dicho de otro modo, aunque la apariencia exterior que un amigo que se ha enfadado realmente con nosotros y una actriz que actúe como si estuviera enfadada será muy parecida, sabemos que la experiencia subjetiva que ambas personas tendrán de esa emoción es muy distinta.

Partiendo de esta distinción, para ser capaces de aventurarnos a responder si una IA podrá tener emociones genuinas, tal y como las percibimos nosotros en nuestras experiencias subjetivas, requeriría que antes fuéramos capaces de entender que es lo que comúnmente llamamos “consciencia” (o, dicho de otro modo a grandes rasgos, la capacidad que tenemos de experimentar algo “en primera persona”), cosa que ya es, actualmente, un enorme reto en el que diferentes disciplinas e investigadores aún no coinciden. Más allá de este reto, estaría después la pregunta de cómo se puede saber, con garantías, que un agente externo posee, efectivamente, experiencias subjetivas de lo que está aparentando. Por ejemplo: podemos saber, al menos por analogía y comparándolo con nuestra propia experiencia subjetiva, que otro ser humano siente dolor cuando sumerge una mano en una olla de agua hirviendo. Sin embargo, un termómetro digital (que es, en el fondo, un ordenador sencillo con un sensor que le permite acceder a cierta parte del mundo exterior, como es la temperatura) será capaz de “percibir” que el agua está ardiendo, pero no sentirá dolor al ser introducido en ella. Podríamos imaginar un termómetro digital más complejo, incluso con una pantalla que mostrase una expresión facial y un altavoz, y programarlo para que, al introducirlo en agua hirviendo, mostrara una mueca de incomodidad y se quejara anunciando que se quema… pero, sabiendo que se trata de un simple termómetro con una interfaz más trabajada, probablemente nadie creería que el termómetro siente el dolor del agua ardiendo. Sin embargo, ¿dónde está el límite de nuestra capacidad para distinguir, claramente, si un agente externo realmente siente una experiencia, o si solo actúa “como si” lo hiciera? ¿Si ese termómetro toma la forma de un robot antropomórfico con complejos sistemas de animación facial y expresión por voz, seguiremos creyendo claramente que ese robot solo se comporta “como si” tuviera la sensación de tocar agua ardiendo, o habrá algo dentro de nosotros que nos hará “conectar” con esa experiencia y nos hará dudar acerca de si lo siente “de verdad”, tal y como nosotros lo haríamos? ¿Qué es lo que hace que, a menudo, los seres humanos seamos capaces de proyectar y casi sentir nosotros mismos las sensaciones, experiencias y emociones que vemos en otros? ¿Cómo funciona ese mecanismo, y por qué es algo que, en mayor o menor medida, o de forma más o menos consciente, hacemos por defecto con otras personas, con animales, o a veces incluso con objetos?

Proyectando y simulando otras mentes: la empatía

Independientemente de si un agente externo puede llegar a sentir emociones genuinas, una cosa es innegable: los seres humanos tendimos a atribuir estados mentales (emociones, intenciones, creencias, etc.) a prácticamente todo lo que nos rodea. El campo de teoría de la mente, dentro de las ciencias cognitivas, se dedica a investigar (entre otras cosas) la forma en que los seres humanos atribuimos una “mente” a otros seres, así como la forma en que usamos esas atribuciones para entender, explicar y predecir sus acciones y comportamientos. Uno de los posibles enfoques usado para explicar cómo funciona este mecanismo se llama teoría de la simulación y parte de la base que, para entender una mente externa a la nuestra, creamos una simulación de lo que creemos que está pasando por esa mente con tal de imaginar su punto de vista, entender las emociones que puede estar sintiendo, e incluso intentar predecir cómo actuará en función de sus deseos y objetivos. De esta capacidad de “imaginar” lo que debe estar pasando dentro de una mente diferente a la nuestra nacería, precisamente, la empatía: de la capacidad entender, simular y “sentir” lo que otra persona está experimentando (o, dicho de otro modo, la capacidad de ponernos en sus zapatos).

Esa capacidad que tenemos para empatizar con otros seres, que se suele desarrollar típicamente entre los dos y los cuatro años de edad como consecuencia de entender que existen “mentes diferentes” a la propia mente, es clave para nuestra forma de relacionarnos socialmente con otros seres humanos y con el mundo que nos rodea; eso hace que, cuando no se desarrolla de forma correcta, pueda conllevar diversos problemas de relación con los demás. Por ejemplo, distintos trastornos de psicopatía y sociopatía suelen ir acompañados de una capacidad limitada (o incluso prácticamente inexistente) de atribuir emociones y sentimientos a los demás, cosa que imposibilita el desarrollo de una relación empática con estos. Por otro lado, muchas formas de discriminación a lo largo de la historia de la humanidad se han sustentado en una “deshumanización” de ciertos colectivos para bloquear la atribución de emociones humanas y dificultar, de ese modo, la empatía hacia tales colectivos (dinámicas en centros penitenciarios, genocidios y conflictos raciales, diferencias de género, etc.).

La empatía, sin embargo, no es un vínculo que solo podamos establecer entre mentes que reconocemos como “humanas”. Más allá de la empatía que normalmente desarrollamos con respecto a animales no humanos (especialmente, aunque no solo, con animales de compañía), los seres humanos tendimos a atribuir una mente a prácticamente todo lo que nos rodea, cosa que nos lleva a menudo a hablar, aunque sea de forma metafórica, en términos de intenciones, deseos y emociones de elementos que, en realidad, no los tienen. Ese proceso de atribuir una mente análoga a la nuestra a casi todo, conocido como antropomorfización, es un recurso que se usa y se explota extensamente en el ámbito de la ficción. El caso más directo sería, seguramente, el que se ha mencionado previamente de una actriz humana: aunque sepamos que la historia que nos cuenta no es real, la actriz es un ser humano del que no tenemos ninguna duda que tiene una mente semejante a la nuestra, y por lo tanto puede tener experiencias similares a las nuestras. Sin embargo, ese mismo efecto se consigue muy a menudo en películas de animación, por ejemplo, en las que los persones son dibujos, o modelos 3D, a veces incluso de animales de apariencia semejante a la humana, o incluso objetos antropomorfizados (con rasgos, expresiones faciales y movimientos corporales humanos), y con los que también creamos vínculos empáticos a través de los que reflejamos, en nosotros mismos, las emociones que esos personajes muestran.

Esta tendencia que los seres humanos tenemos de atribuir una mente a agentes exteriores y empatizar con nuestro entorno, tiene su aplicación evidente en el campo de la IA. Desde la “humanización” de la voz de ciertos asistentes artificiales (como Siri en el caso de Apple, Alexa en el caso de Amazon, etc.), la antropomorfización del aspecto de asistentes en ciertos programas (¿quién no recuerda, quizás con una mezcla de nostalgia e irritación, al clip asistente del Microsoft Word y sus sugerentes e incómodos juegos de cejas?), la atribución de nombres y caras de perfil a algunos asistentes conversacionales (o chatbots), o la antropomorfización casi completa de robots de última generación, todas esas técnicas hacen que sea más fácil crear relaciones empáticas con esas IAs, así como atribuirles una mente y estados emocionales. Sabiendo que los seres humanos tenemos una tendencia a hacer eso, la pregunta es:¿cómo puede afectar, todo esto, al futuro de la forma en la que nos relacionamos con la tecnología inteligente? ¿Qué oportunidades potenciales, así como posibles riesgos, encontramos al combinar esta predisposición natural humana con la creación de agentes artificiales de apariencia más o menos antropomórfica?

Robots, emociones y relaciones sociales: oportunidades y riesgos para el futuro

Por un lado, aprender a aprovechar la forma que tenemos los seres humanos de “proyectar una mente” en otras cosas y así poder establecer relaciones empáticas puede resultar muy útil para naturalizar y hacer más agradable nuestra forma de relacionarnos con agentes artificiales. El contenido emocional de nuestras interacciones (la forma en que hablamos, el lenguaje no verbal, nuestra expresión facial, etc.) es una parte central de la comunicación con otros seres humanos, y es a través de este contenido que a menudo entendemos mensajes que pueden no aparecer de forma explícita en lo que se dice, pero si en la forma en como se dice. Eso puede ser especialmente útil en casos, por ejemplo, como el de los robots diseñados para el cuidado médico. En estos casos, el robot no solo tiene que desempeñar un papel puramente funcional, sino que, al relacionarse con pacientes humanos que pueden estar en momentos de vulnerabilidad, o en situaciones emocionales complicadas, poder “leer” y responder apropiadamente a las emociones del paciente humano puede hacer que la interacción sea mucho más reconfortante para éste. Esto no significa, por supuesto, que el paciente deba creer, como requisito para que la interacción sea más agradable, que el robot realmente siente esas emociones, pero al ver que esa interacción tiene en cuenta su estado de ánimo podría ayudar al paciente a sentir que el robot, en cierto modo, “entiende” lo que le pasa y le proporciona un mejor acompañamiento en esa situación de vulnerabilidad.

Lo mismo podría decirse de asistentes personales en campos como la vida privada o profesional, sistemas de tutorizaje inteligente en educación, o incluso robots de compañía. Un asistente que entiende la emoción que hay tras una interacción (quizás detectando una urgencia, la frustración del usuario o usuaria, un tono relajado y abierto a una interacción más larga, etc.) puede, igual que los humanos al interactuar entre nosotros, entender mejor la forma en que se puede dar respuesta a esa interacción. Un sistema de tutorizaje inteligente en educación online, por ejemplo, podría detectar que un alumno está frustrado e irritado porque es incapaz de resolver un ejercicio. Ante dicho estado emocional, el sistema de tutorizaje podría buscar formas para relajar y devolver la confianza al alumno para poder remprender el problema con mayor claridad, sin el estrés acumulado hasta ese momento; por ejemplo, el sistema podría repasar paso a paso las bases del ejercicio en el que el alumno trabaja, o utilizar algún ejemplo parecido de menor complejidad para ayudar al alumno a ganar confianza y seguridad en sus conocimientos. Esto puede resultar útil no solo permitiendo que el sistema pueda entender las emociones tras la consulta del alumno, sino también adecuando la forma en que éste podría responder a sus interacciones (a nivel de tono de los mensajes, expresiones faciales y movimientos, vocabulario, etc.).

Sin embargo, estos avances también pueden tener un lado oscuro y, como todo en la historia de la tecnología, podrían usarse de formas menos deseables. Sabiendo que los seres humanos tendemos a empatizar y a adaptar nuestras interacciones con agentes en los que proyectamos una mente, el hecho de leer y simular emociones podría utilizarse para manipular, de forma sutil y casi inconsciente, nuestras propias decisiones con fines comerciales, políticos o ideológicos. En un mundo donde prácticamente todas las capas de nuestras vidas están digitalizadas, donde cada vez todo está más interconectado (incluyendo nuestra vida personal, social y profesional), y donde la IA se implanta cada vez a mayor escala, el uso de esas sutiles manipulaciones de nuestras respuestas emocionales, muchas veces inconscientes, podría llevar a una forma de subversión generalizada a unos intereses que poco tendrían que ver con el beneficio general de la población. El paralelismo de esta forma de explotar los vínculos empáticos ya existe en el ser humano con la figura del charlatán ambulante que, a través de crear un vínculo de familiaridad y confianza con un cliente potencial, le manipula y conduce hasta conseguir el objetivo de vender un producto, contratar un servicio, o tomar una decisión concreta que, una vez pensada en frío, el cliente quizás se arrepiente de haber tomado.

Otro riesgo que se esconde tras la capacidad de la IA para entender y reaccionar a las emociones se encuentra en la posibilidad de que las relaciones sociales se “tecnifiquen”. De la misma forma en que una IA capaz de percibir y reaccionar a estados emocionales está, en el fondo, aprendiendo las “reglas” de las relaciones sociales, existe el riesgo de que nosotros mismos, ya sea cuando interaccionamos con una IA, o ya sea de forma creciente en las relaciones sociales con otras personas, empecemos a basar esa tipo de interacciones en las “reglas” que hay detrás, más que en nuestra propia intuición natural para hacerlo. Desde el punto de vista computacional y funcional, la emoción que nosotros mostramos es, para la IA, un input al que, mediante una serie de reglas heurísticas, le corresponde un determinado output (o un rango de posibles outputs). En el caso de estar interactuando con otro ser humano, una misma forma de iniciar una interacción no siempre tendrá la misma reacción, puesto que también dependerá del estado emocional de la persona con la que se interactúa: las personas percibimos y nos adaptamos al estado emocional de los demás, y no es extraño que esos estados emocionales ajenos afecten la forma en la que nos desenvolvemos en una interacción concreta. Aunque sea capaz de percibir y simular emociones, una IA no tendrá un estado emocional propio que nos pida, tal y como pasa en las interacciones con otros seres humanos, un entendimiento y una compatibilización de nuestros distintos puntos de vista y nuestros distintos estados de ánimo. Si, a través de potenciar las relaciones emocionales con sistemas de IA basados en regla, nos estamos entrenando a nosotros mismos para entender las reglas detrás y aprender a “jugar al juego” de las interacciones sociales, ¿existe el riesgo de que nos estemos entrenando, en el fondo, para calcular, fingir y manipular el uso de las emociones para obtener la respuesta que queremos?

Por otro lado, pero siguiendo la misma línea, también se abre una pregunta acerca de los estándares de las relaciones sociales. Para que una IA puede reaccionar ante una emoción mostrada en un usuario, la IA necesita algún tipo de regla; por ejemplo, una regla estadística. Esta regla puede capturar la forma en que mayoritariamente se reacciona a una determinada situación, pero la pregunta es: ¿aunque sea mayoritaria, esa regla es igualmente aplicable en todos los contextos, situaciones, o incluso grupos sociales o culturales? Al definir un estándar para determinar cómo debe reaccionar una IA en una situación concreta, existe el riesgo de estar creando una idea de “normalidad” que puede acabar por imponer ciertos patrones de relaciones sociales que ni tienen por qué ser universales (aunque sean mayoritarios), ni tienen porqué ser extrapolables a otros contextos, ni tienen porqué ser compartidos por otros grupos sociales o individuos. ¿Podría, esa estandarización, poner en riesgo otras formas igualmente válidas de interacción social y emocional que, poco a poco, podrían caer en el olvido al no ser “compatibles” con los sistemas de IA?

La creciente capacidad de los sistemas de IA para percibir y mostrar emociones abre las puertas a una nueva dimensión de las interacciones sociales entre los seres humanos y las máquinas. Detrás de esa puerta hay grandes oportunidades para hacer de nuestra interacción con los sistemas de IA algo más natural, orgánico, gratificante y eficaz, pero también hay riesgos potenciales que apuntan tanto a un posible uso mal intencionado de esas tecnologías, como a los posibles efectos que esta tecnificación de las interacciones sociales pueda tener sobre las relaciones entre los propios seres humanos. Como en la mayoría de avances tecnológicos, es muy difícil prever en qué y hasta qué punto este avance afectará el futuro de nuestra forma de relacionarnos. Sin embargo, hay un punto importante a tener en cuenta que nos puede dar valiosas herramientas para entablar esa nueva etapa de las relaciones entre las personas y las máquinas desde una posición más informada y con más herramientas para sacar el máximo provecho de dichos avances, al mismo tiempo que nos protegemos de posibles efectos adversos. Se trata de recordar la diferencia que hay entre una emoción genuina y una emoción simulada, y tener presente cuál de las dos es la que puede mostrar un sistema de IA… al menos, en lo que refiere a un futuro próximo.

Per què empatitzem amb els robots?

El futur de la IA, les emocions i les relacions socials

Som a a l’any 2001, camí a Júpiter i a bord de la nau Discovery One. El Dr. David Bowman, després d’haver salvat la seva vida pels pèls, es dirigeix al nucli del processador del HAL 9000, un ordinador equipat amb personalitat humana que, amb l’objectiu d’assegurar l’èxit de la missió, ha intentat acabar amb la vida del Dr. Bowman. Mentre aquest desconnecta manualment les diferents unitats del nucli del HAL 9000, l’ordinador li parla: «Dave, només ha estat un error de càlcul, però ara ja estic bé». Quan això no funciona, el HAL 9000 canvia d’estratègia: li demana i li suplica al Dr. Bowman que no el desconnecti. Quan això tampoc funciona, l’ordinador adopta un nou enfocament: diu que té por. Diu que la seva ment se n’està anant. Diu que pot sentir-ho. El Dr. Bowman, sense fer cas a les paraules del HAL 9000, aconsegueix desactivar-lo i recupera el control de la nau espacial. Aquesta és, potser, una de les escenes més famoses del clàssic cinematogràfic de Stanley Kubrick, «2001: A Space Odyssey». Allà se’ns presenta un superordinador que no només posseeix una intel·ligència extraordinària, sinó també una capacitat d’interaccionar amb els éssers humans que, ara per ara, queda lluny de la tecnologia que tenim en el nostre món actual. Com a part d’aquesta extraordinària capacitat d’interacció, l’ordinador fa referència a les seves emocions i a la seva experiència subjectiva: diu que té por i que pot sentir com la seva ment se’n va. Pot, el HAL 9000, sentir això realment, o és només una estratègia per protegir-se de la determinació del Dr. Bowman de desconnectar-lo?

Encara que es tracti d’obres de ciència ficció, algunes novel·les i adaptacions cinematogràfiques com ara «2001: A Space Odyssey», de Stanley Kubrick, pel·lícules com «Ex Machina», d’Alex Garland, o «AI: Artificial Intelligence», de Steven Spielberg, o clàssics de la literatura com els relats recopilats a «I, robot», d’Isaac Asimov, han explorat nombroses vegades les possibles relacions entre la intel·ligència artificial (IA) i les emocions. Encara que el que veiem en aquestes obres encara queda lluny de la tecnologia actual, les preguntes que obren són cada vegada més rellevants per entendre els efectes que la integració entre la IA i les emocions poden arribar a tenir en un futur proper dels avenços tecnològics. Quines són les preguntes que ens hem de fer quan parlem d’IA i emocions? On acaba allò humà i comença allò artificial? Com podria afectar, en les nostres relacions socials, conviure amb robots capaços d’entendre i mostrar emocions?

Emocions percebudes: realitat, o simulació?

Tot i que la quantitat de temes en els quals ens podríem centrar, entorn a aquestes preguntes, és enorme (i, certament, impossible de condensar en una publicació d’aquesta mida), hi ha una pregunta fonamental i recurrent que, tant en la ciència ficció, com en converses al voltant del futur de la tecnologia, ens fem sovint: ¿podrà la IA arribar a tenir emocions algun dia? En endinsar-nos en aquesta pregunta, és important partir d’una diferència important: una cosa és sentir emocions, i una altra molt diferent és simular, o fingir emocions. Aquesta distinció és clau perquè, encara que en ambdós casos podem percebre, des de fora, que hi ha una emoció present, sabem que l’emoció no és genuïna en els dos casos: per exemple, una actriu pot fer veure que està enfadada amb nosaltres, però sabem que en realitat només està simulant, o fingint sentir aquesta emoció, però que no està realment enfadada. Dit d’una altra manera, tot i que l’aparença exterior que un amic que s’ha enfadat realment amb nosaltres i una actriu que actuï com si estigués enfadada serà molt semblant, sabem que l’experiència subjectiva que les dues persones tindran d’aquesta emoció és molt diferent.

Partint d’aquesta distinció, per tal de ser capaços d’aventurar-nos a respondre si una IA podrà tenir emocions genuïnes, tal i com les percebem nosaltres en les nostres experiències subjectives, caldria que abans fóssim capaços d’entendre què és el que normalment anomenem «consciència» (o, dit d’una altra manera i a grans trets, la capacitat que tenim d’experimentar alguna cosa «en primera persona»), cosa que ja és, actualment, un enorme repte en què diferents disciplines i investigadors encara no coincideixen. Més enllà d’aquest repte, després sorgiria la pregunta de com es pot saber, amb garanties, que un agent extern posseeix, efectivament, experiències subjectives del que està mostrant. Per exemple: podem saber, si més no per analogia i comparant-ho amb la nostra pròpia experiència subjectiva, que un altre ésser humà sent dolor quan submergeix una mà en una olla d’aigua bullint. No obstant això, un termòmetre digital (que és, en el fons, un ordinador senzill amb un sensor que li permet accedir a certa part del món exterior, com ara la temperatura) serà capaç de «percebre» que l’aigua està cremant, però no sentirà dolor quan l’hi submergim. Podríem imaginar un termòmetre digital més complex, fins i tot amb una pantalla que mostrés una expressió facial i un altaveu, i programar-lo perquè, en introduir-lo en aigua bullint, mostrés una ganyota d’incomoditat i es queixés anunciant que es crema… però, sabent que es tracta d’un simple termòmetre amb una interfície més treballada, probablement ningú creuria que el termòmetre sent el dolor de l’aigua cremant. No obstant això, on està el límit de la nostra capacitat per distingir, clarament, si un agent extern realment sent una experiència, o si només actua «com si» ho fes? ¿Si aquest termòmetre pren la forma d’un robot antropomòrfic amb complexos sistemes d’animació facial i expressió per veu, seguirem creient clarament que aquest robot només es comporta «com si» tingués la sensació de tocar aigua cremant, o hi haurà alguna cosa dins nostre que ens farà «connectar» amb aquesta experiència i ens farà dubtar sobre si la sent «de veritat», tal i com nosaltres ho faríem? Què és el que fa que, sovint, els éssers humans siguem capaços de projectar i gairebé sentir nosaltres mateixos les sensacions, experiències i emocions que veiem en els altres? Com funciona aquest mecanisme, i per què és una cosa que, en major o menor mesura, o de forma més o menys conscient, apliquem per defecte amb altres persones, amb animals, o de vegades fins i tot amb objectes?

Projectant i simulant altres ments: l’empatia

Independentment de si un agent extern pot arribar a sentir emocions genuïnes, una cosa és innegable: els éssers humans tendim a atribuir estats mentals (emocions, intencions, creences, etc.) a pràcticament tot el que ens envolta. El camp de teoria de la ment, dins de les ciències cognitives, es dedica a investigar (entre d’altres coses) la forma en què els éssers humans atribuïm una «ment» a altres éssers, així com la forma en què fem servir aquestes atribucions per entendre , explicar i predir les seves accions i comportaments. Un dels possibles enfocaments usat per explicar com funciona aquest mecanisme s’anomena teoria de la simulació i parteix de la base que, per tal d’entendre una ment externa a la nostra, creem una simulació del que creiem que està passant per aquesta ment per tal de imaginar el seu punt de vista, entendre les emocions que pot estar sentint, i fins i tot intentar predir com actuarà en funció dels seus desitjos i objectius. D’aquesta capacitat de «imaginar» el que deu estar passant dins d’una ment diferent a la nostra naixeria, precisament, l’empatia: de la capacitat d’entendre, simular i «sentir» el que una altra persona està experimentant (o, dit d’una altra manera, de la capacitat de posar-nos al seu lloc).

Aquesta capacitat que tenim per empatitzar amb altres éssers, que se sol desenvolupar típicament entre els dos i els quatre anys d’edat com a conseqüència d’entendre que hi ha «ments diferents» a la pròpia ment, és clau per a la nostra manera de relacionar-nos socialment amb altres éssers humans i amb el món que ens envolta; això fa que, quan no es desenvolupa de forma correcta, pugui comportar diversos problemes de relació amb els altres. Per exemple, diferents trastorns de psicopatia i sociopatia solen anar acompanyats d’una capacitat limitada (o fins i tot pràcticament inexistent) d’atribuir emocions i sentiments als altres, cosa que impossibilita el desenvolupament d’una relació empàtica cap a aquests. D’altra banda, moltes formes de discriminació al llarg de la història de la humanitat s’han sustentat en una «deshumanització» de certs col·lectius per tal de bloquejar l’atribució d’emocions humanes i dificultar, d’aquesta manera, l’empatia cap a aquests col·lectius (dinàmiques en centres penitenciaris, genocidis i conflictes racials, diferències de gènere, etc.).

L’empatia, però, no és un vincle que només puguem establir entre ments que reconeixem com a «humanes». Més enllà de l’empatia que normalment desenvolupem pel que fa a animals no humans (especialment, encara que no només, amb animals de companyia), els éssers humans tendim a atribuir una ment a pràcticament tot el que ens envolta, cosa que ens porta sovint a parlar, encara que sigui de forma metafòrica, en termes d’intencions, desitjos i emocions d’elements que, en realitat, no en tenen. Aquest procés d’atribuir una ment anàloga a la nostra a gairebé tot, conegut com a “antropomorfització”, és un recurs que s’utilitza i s’explota extensament en l’àmbit de la ficció. El cas més directe seria, segurament, el que ja s’ha dit abans d’una actriu humana: encara que sapiguem que la història que ens explica no és real, l’actriu és un ésser humà de qui no tenim cap dubte que té una ment semblant a la nostra, i per tant pot tenir experiències similars a les nostres. No obstant això, aquest mateix efecte s’aconsegueix molt sovint en pel·lícules d’animació, per exemple, en les quals els persones són dibuixos, o models 3D, de vegades fins i tot d’animals d’aparença semblant a la humana, o fins i tot objectes antropomorfitzats (amb trets, expressions facials i moviments corporals humans), i amb qui també creem vincles empàtics a través dels quals reflectim, en nosaltres mateixos, les emocions que aquests personatges mostren.

Aquesta tendència que els éssers humans tenim d’atribuir una ment a agents exteriors i empatitzar amb el nostre entorn té la seva aplicació evident en el camp de la IA. Des de la «humanització» de la veu de certs assistents artificials (com Siri en el cas d’Apple, Alexa en el cas d’Amazon, etc.), l’antropomorfització de l’aspecte d’assistents en certs programes (qui no recorda, potser amb una barreja de nostàlgia i irritació, al clip assistent del Microsoft Word i els seus suggerents i incòmodes jocs de celles?), l’atribució de noms i cares de perfil a alguns assistents conversacionals (o chatbots), o l’antropomorfització gairebé completa de robots d’última generació, totes aquestes tècniques fan que sigui més fàcil crear relacions empàtiques amb aquestes IAs, així com atribuir-los una ment i estats emocionals. Sabent que els éssers humans tenim una tendència a fer això, la pregunta és: com pot afectar, tot això, al futur de la forma en què ens relacionem amb la tecnologia intel·ligent? Quines oportunitats potencials, així com possibles riscos, trobem en combinar aquesta predisposició natural humana amb la creació d’agents artificials d’aparença més o menys antropomòrfica?

Robots, emocions i relacions socials: oportunitats i riscos pel futur

D’una banda, aprendre a aprofitar la forma que tenim els éssers humans de «projectar una ment» en altres coses i així poder establir relacions empàtiques pot resultar molt útil per tal de naturalitzar i fer més agradable la nostra forma de relacionar-nos amb agents artificials. El contingut emocional de les nostres interaccions (la forma en què parlem, el llenguatge no verbal, la nostra expressió facial, etc.) és una part central de la comunicació amb altres éssers humans, i és a través d’aquest contingut que sovint entenem missatges que poden no aparèixer de forma explícita en el que es diu, però si en la forma en com es diu. Això pot ser especialment útil en casos, per exemple, com el dels robots dissenyats per a l’assistència hospitalària. En aquests casos, el robot no només ha de tenir un paper purament funcional, sinó que, en relacionar-se amb pacients humans que poden trobar-se en moments de vulnerabilitat, o en situacions emocionals complicades, poder «llegir» i respondre apropiadament a les emocions del pacient humà pot fer que la interacció sigui molt més reconfortant per a aquest. Això no vol dir, és clar, que el pacient hagi de creure, com a requisit perquè la interacció sigui més agradable, que el robot realment sent aquestes emocions, però el simple fet de veure que aquesta interacció té en compte el seu estat d’ànim podria ajudar al pacient a sentir que el robot, en certa manera, «entén» el que li passa i li proporciona un millor acompanyament en aquesta situació de vulnerabilitat.

El mateix es podria dir d’assistents personals en camps com ara la vida privada o professional, sistemes de tutorització intel·ligent en educació, o fins i tot robots de companyia. Un assistent que entén l’emoció que hi ha dins d’una interacció (potser detectant una urgència, la frustració de l’usuari o usuària, un to relaxat i obert a una interacció més llarga, etc.) pot, igual que els humans en interactuar entre nosaltres, entendre millor la forma en què es pot donar resposta a aquesta interacció. Un sistema de tutorització intel·ligent en educació online, per exemple, podria detectar que un alumne està frustrat i irritat perquè és incapaç de resoldre un exercici. Davant d’aquest estat emocional, el sistema de tutorització podria buscar maneres per relaxar i tornar la confiança a l’alumne per tal de poder reemprendre el problema amb més claredat, sense l’estrès acumulat fins al moment; per exemple, el sistema podria repassar pas a pas les bases de l’exercici en què l’alumne treballa, o utilitzar algun exemple semblant de menys complexitat per tal d’ajudar a l’alumne a guanyar confiança i seguretat en els seus coneixements. Això podria ser útil no només permetent que el sistema pugui entendre les emocions dins la consulta de l’alumne, sinó també adequant la forma en què aquest podria respondre a les seves interaccions (a nivell de to dels missatges, expressions facials i moviments, vocabulari, etc.).

No obstant això, aquests avenços també poden tenir un costat fosc i, com tot en la història de la tecnologia, podrien usar-se de formes menys desitjables. Sabent que els éssers humans tendim a empatitzar i a adaptar les nostres interaccions amb agents en què projectem una ment, el fet de llegir i simular emocions podria utilitzar-se per manipular, de forma subtil i gairebé inconscient, les nostres pròpies decisions amb finalitats comercials, polítiques o ideològiques. En un món on pràcticament totes les capes de les nostres vides estan digitalitzades, on cada vegada tot està més interconnectat (incloent la nostra vida personal, social i professional), i on la IA s’implanta cada vegada a una escala més global, l’ús d’aquestes subtils manipulacions de les nostres respostes emocionals, moltes vegades inconscients, podria portar a una forma de subversió generalitzada a uns interessos que poc tindrien a veure amb el benefici general de la població. El paral·lelisme d’aquesta forma d’explotar els vincles empàtics ja existeix en l’ésser humà amb la figura del venedor ambulant que, a través de crear un vincle de familiaritat i confiança amb un client potencial, el manipula i condueix fins a aconseguir l’objectiu de vendre un producte, contractar un servei, o prendre una decisió concreta que, un cop pensada en fred, el client potser es penedeix d’haver pres.

Un altre risc que s’amaga darrere de la capacitat de la IA per entendre i reaccionar a les emocions es troba en la possibilitat de que les relacions socials es «tecnifiquin». Tal i com una IA capaç de percebre i reaccionar a estats emocionals està, en el fons, aprenent les «regles» de les relacions socials, hi ha el risc que nosaltres mateixos, ja sigui quan interaccionem amb una IA, o ja sigui de forma creixent en les relacions socials amb altres persones, comencem a basar aquest tipus d’interaccions en les «regles» que hi ha darrere, més que no pas en la nostra pròpia intuïció natural per fer-ho. Des del punt de vista computacional i funcional, l’emoció que nosaltres mostrem és, per la IA, un input a què, mitjançant una sèrie de regles heurístiques, li correspon un determinat output (o un rang de possibles outputs). En el cas d’estar interactuant amb un altre ésser humà, una mateixa forma d’iniciar una interacció no sempre tindrà la mateixa reacció, ja que també dependrà de l’estat emocional de la persona amb la qual s’interactua: les persones percebem i ens adaptem a l’estat emocional dels altres, i no és estrany que aquests estats emocionals aliens afectin la forma en què ens movem en una interacció concreta. Encara que sigui capaç de percebre i simular emocions, una IA no tindrà un estat emocional propi que ens demani, tal com passa en les interaccions amb altres éssers humans, una entesa i una compatibilització dels nostres diferents punts de vista i els nostres diferents estats d’ànim. Si, a través de potenciar les relacions emocionals amb sistemes d’IA basats en regles, ens estem entrenant a nosaltres mateixos per entendre les regles darrere i aprendre a «jugar a el joc» de les interaccions socials, hi ha el risc que ens estiguem entrenant , en el fons, per calcular, fingir i manipular l’ús de les emocions per tal d’obtenir la resposta que volem?

D’altra banda, però seguint la mateixa línia, també s’obre una pregunta sobre els estàndards de les relacions socials. Perquè una IA pugui reaccionar davant d’una emoció mostrada en un usuari, la IA necessita algun tipus de regla; per exemple, una regla estadística. Aquesta regla pot capturar la forma en què majoritàriament es reacciona a una determinada situació, però la pregunta és: encara que sigui majoritària, aquesta regla és igualment aplicable en tots els contextos, situacions, o fins i tot grups socials o culturals? En definir un estàndard per determinar com ha de reaccionar una IA en una situació concreta, hi ha el risc d’estar creant una idea de «normalitat» que pot acabar per imposar certs patrons de relacions socials que ni tenen per què ser universals (encara que siguin majoritaris), ni tenen perquè ser extrapolables a d’altres contextos, ni tenen perquè ser compartits per altres grups socials o individus. Podria, aquesta estandardització, posar en risc altres formes igualment vàlides d’interacció social i emocional que, a poc a poc, podrien caure en l’oblit en no ser «compatibles» amb els sistemes d’IA?

La creixent capacitat dels sistemes d’IA per a percebre i mostrar emocions obre les portes a una nova dimensió de les interaccions socials entre els éssers humans i les màquines. Darrere d’aquesta porta hi ha grans oportunitats per fer de la nostra interacció amb els sistemes d’IA una cosa més natural, orgànica, gratificant i eficaç, però també hi ha riscos potencials que apunten tant a un possible ús mal intencionat d’aquestes tecnologies, com als possibles efectes que aquesta tecnificació de les interaccions socials pugui tenir sobre les relacions entre els propis éssers humans. Com en la majoria d’avenços tecnològics, és molt difícil preveure en què i fins a quin punt aquest avanç afectarà el futur de la nostra forma de relacionar-nos. No obstant això, hi ha un punt important a tenir en compte que ens pot donar eines molt valuoses per tal d’entaular aquesta nova etapa de les relacions entre les persones i les màquines des d’una posició més informada i amb més eines per treure el màxim profit d’aquests avenços, a l’hora que ens protegim de possibles efectes adversos. Es tracta de recordar la diferència que hi ha entre una emoció genuïna i una emoció simulada, i tenir present quina de les dues és la que pot mostrar un sistema d’IA… com a mínim, pel que fa a un futur proper.